Lecture 14

• Recap: Linear Classification

• Loss Function & Optimization

• Regularization

• Overfitting & Underfitting

• Optimization

Lecture 15

• Neural Networks 신경망

• Introduction

• Backpropagation 역전달(역전파)

Lecture 16

•Introduction to Deep Learning

• Recap:

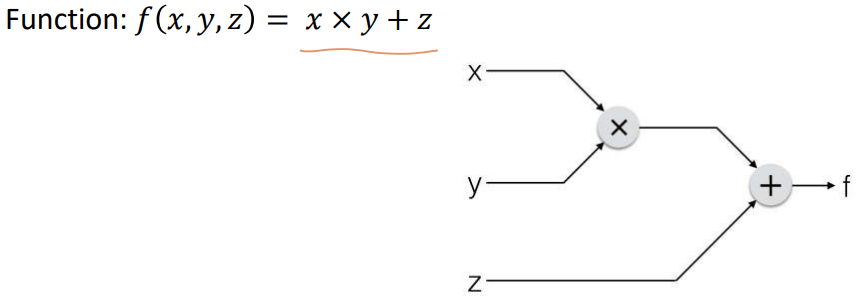

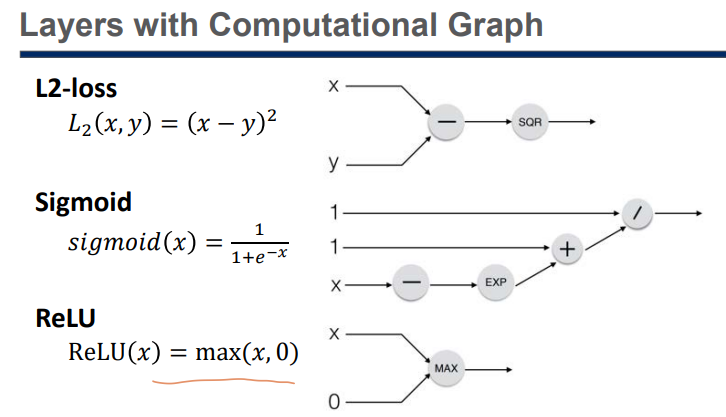

• Computational Graph

• Backpropagation

• Brief History

• Types of Layers

• Fully Connected (FC), Convolution, Pooling, Softmax…

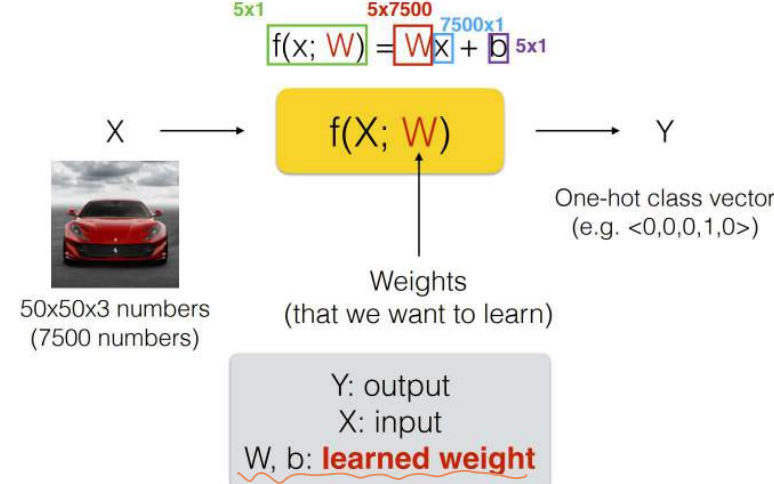

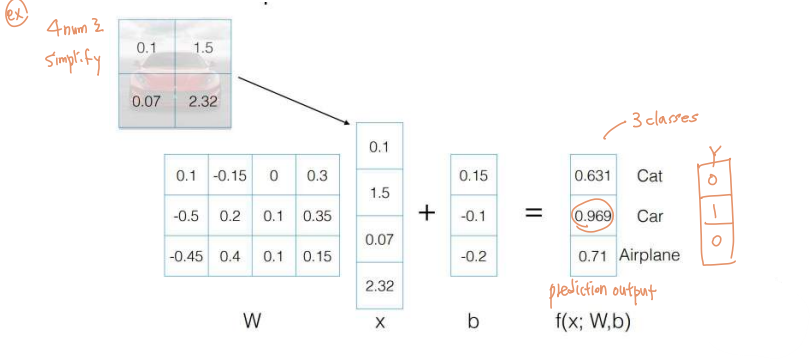

Linear Classification

Loss Function & Optimization

나의첫 5.8장 p.205~213

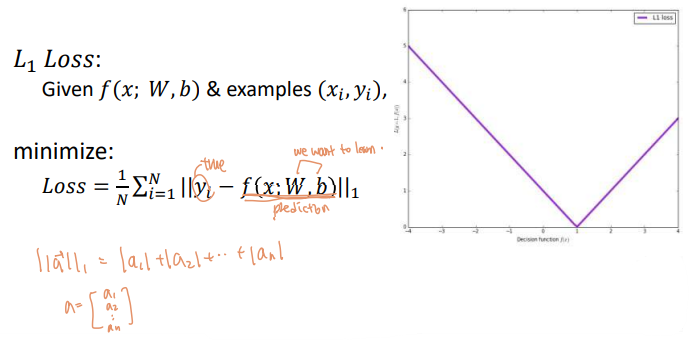

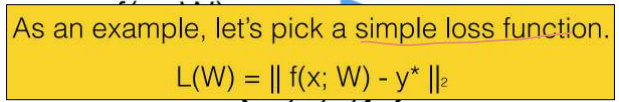

Loss Function 손실함수

출력값과 정답의 차이를 구하기 위한 함수임.

출력값과 정답이 일치할수록 손실함수의 값은 적고, 불일치할수록 손실함수의 값은 큼.

보통 회귀에는 평균제곱오차를, 분류 문제에는 크로스 엔트로피를 손실함수로 사용함.

궁극적인 목적은 높은 '정확도'를 끌어내는 매개변수 값을 찾는 것임.

Overfitting vs. Underfitting

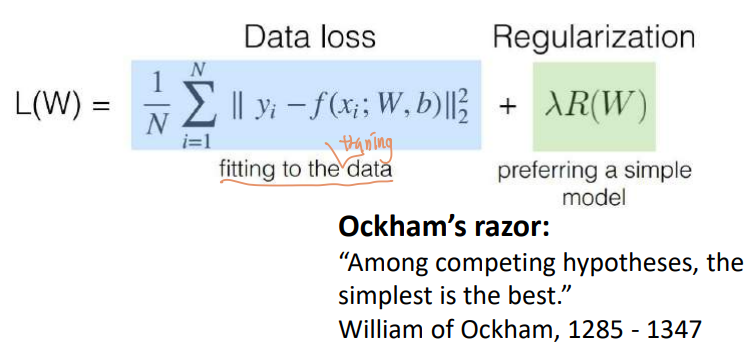

Regularization 규제, 정규화

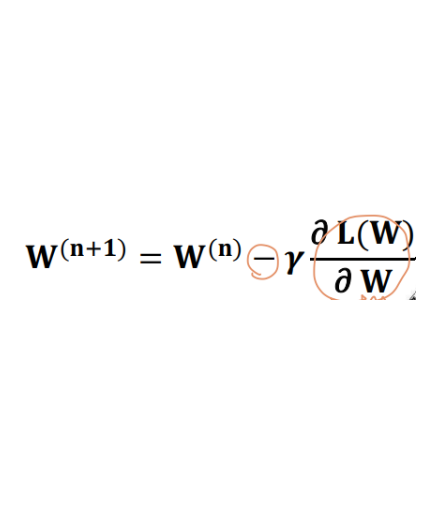

Optimization 최적화

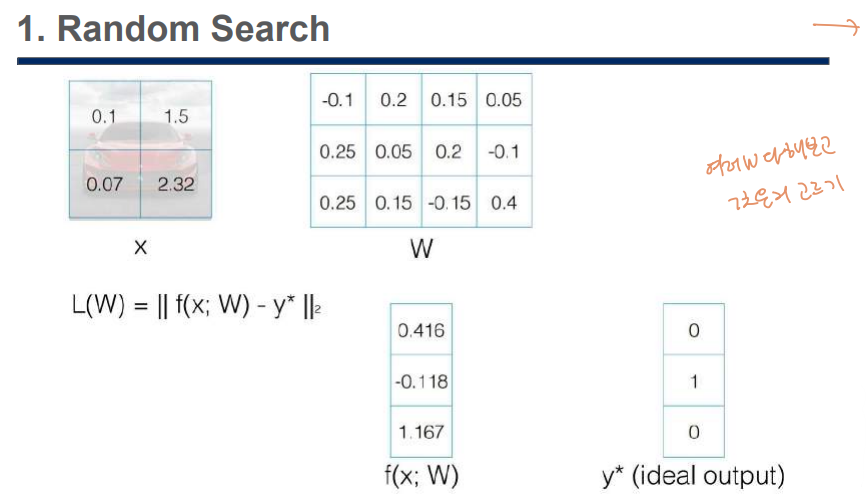

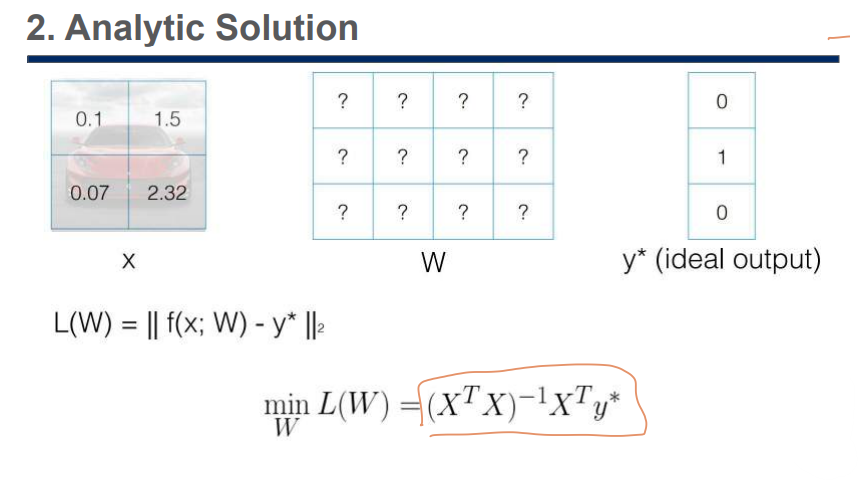

Find W that minimize a loss function (L)

매개변수(가중치, 편향값)를 조절해서 손실함수의 값을 최저로 만드는 과정.

최적화 과정은 옵티마이저(oprimizer)를 통해 이뤄짐.

옵티마이저는 역전파(back propagation) 과정을 수행해서 딥러닝 모델의 매개변수를 최적화함.

W를 브루트포스 -> too slow (too naive)

분석 -> very hard to find

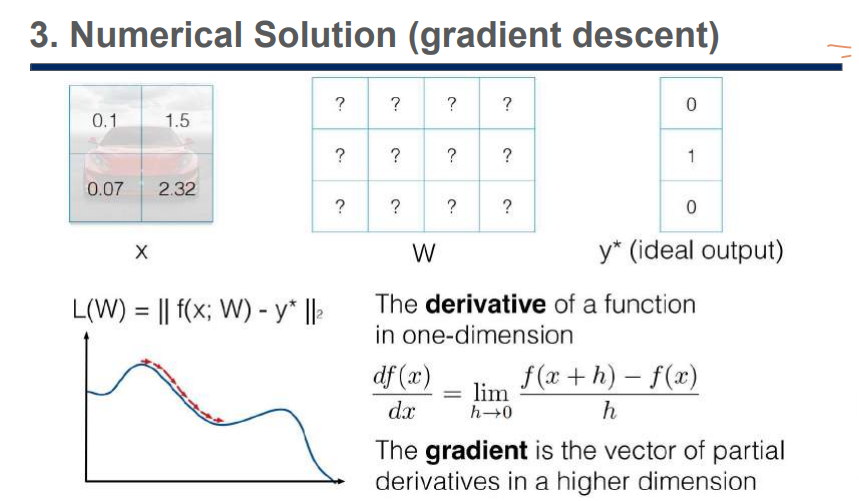

대표적인 최적화 방법은 경사하강법. (그나마 젤 나음.)

반복적으로 손실함수에 대한 모델 매개변수의 미분값을 구한 후, 그 미분값의 반대 방향으로

매개변수를 조절해나가면 결국에는 최저 손실함수 값에 도달함.

다음과 같은 이슈가 있긴 함.

1. Local minima

2. Exploding gradient (can be very big)

3. Inexact gradient (inaccurate)

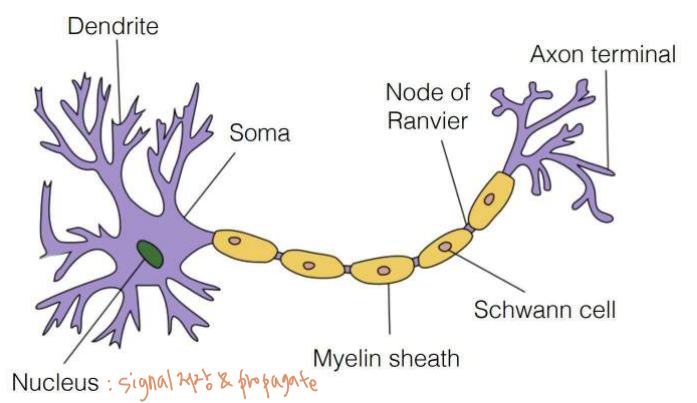

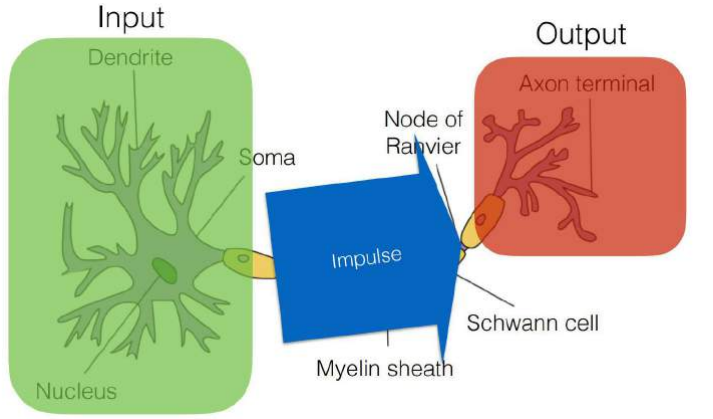

Deep Learning is motivated by human brain

Neural Networks 신경망

모두딥 6~9장 p.102~126

밑시딥 4장 p.107~147

https://dad-rock.tistory.com/m/870

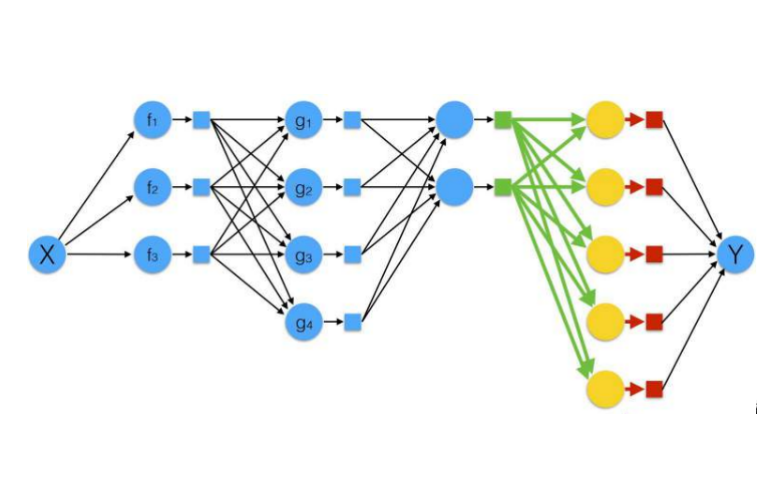

a set of neurons (atomic functions) connected in a non-linear way

신경망 학습

데이터로부터 매개변수의 값을 정하는 방법

(데이터를 보고 학습할 수 있음)

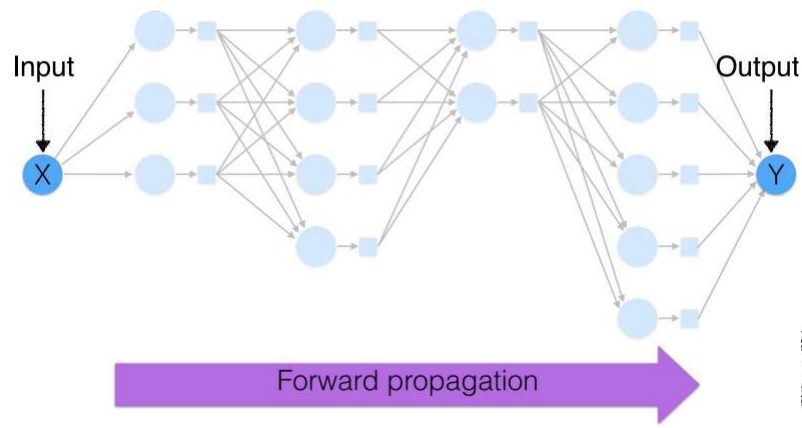

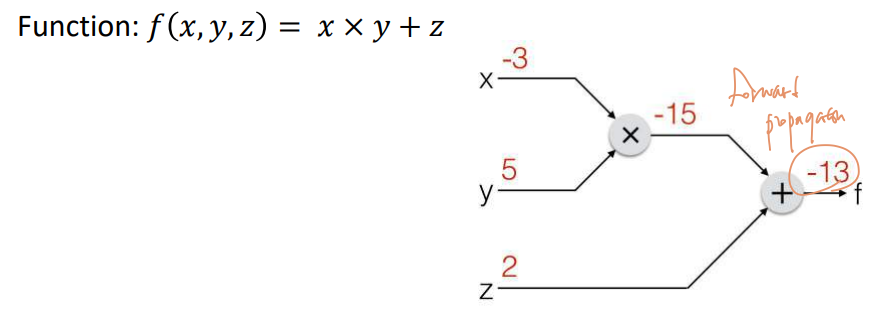

Forward Propagation 순전파

나의첫 5.8.1장 p.204

딥러닝에 값을 입력해서 출력을 얻는 과정.

왼쪽에서 오른쪽으로 데이터가 흘러가는 과정을 순전파라고 하며,

순전파에 의해 딥러닝의 출력값을 얻을 수 있음

Now, how do we learn each function?

i.e. weights (parameters) of each atomic function

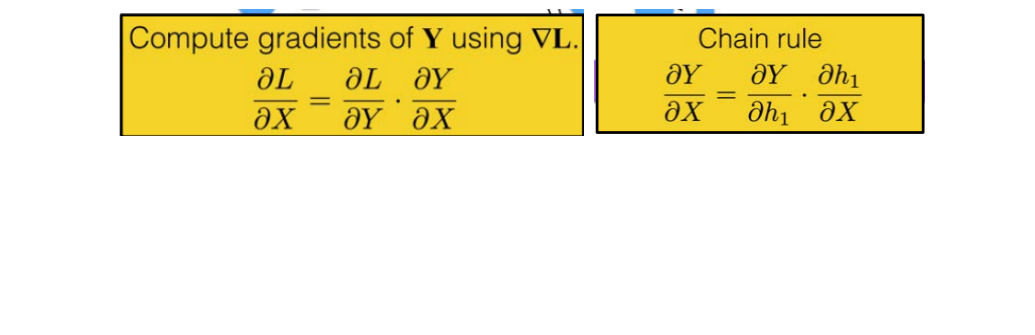

=> training을 위해 Y에서 X방향으로 역전파!

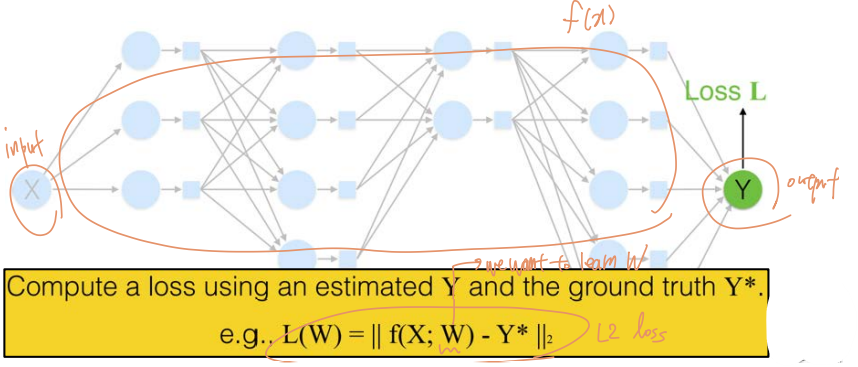

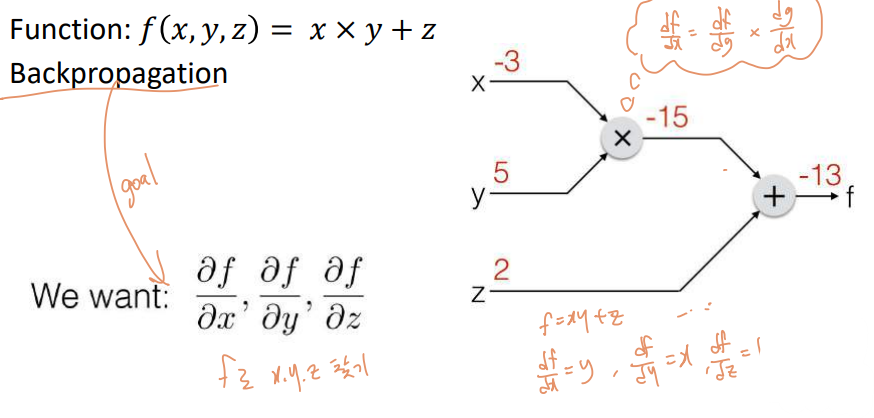

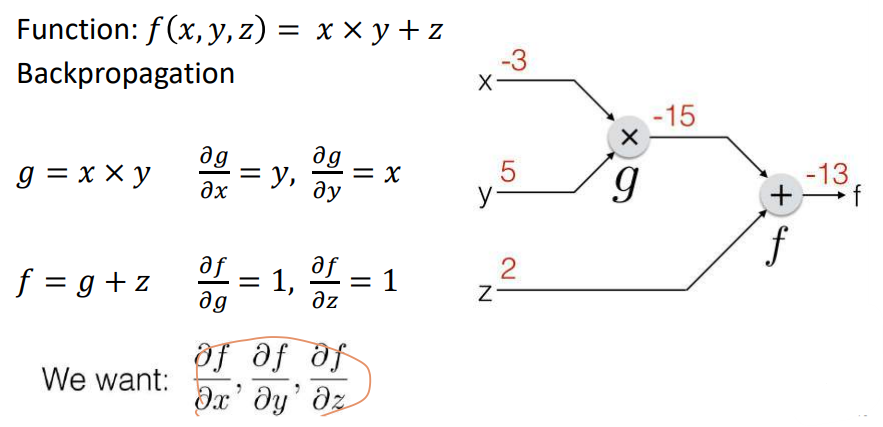

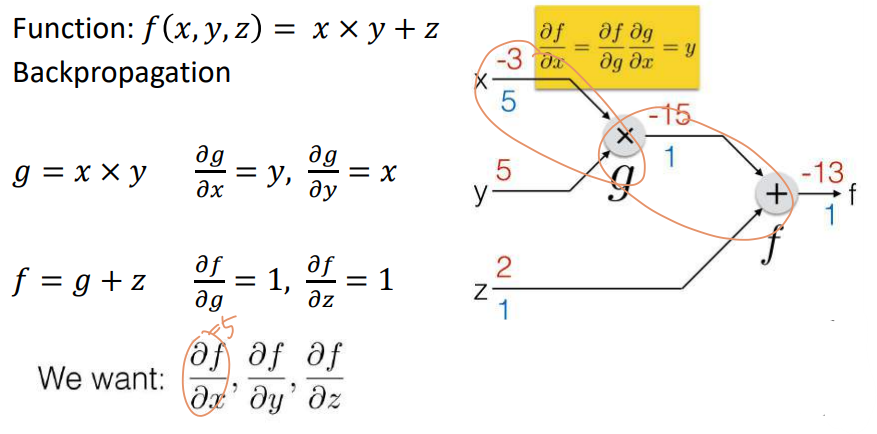

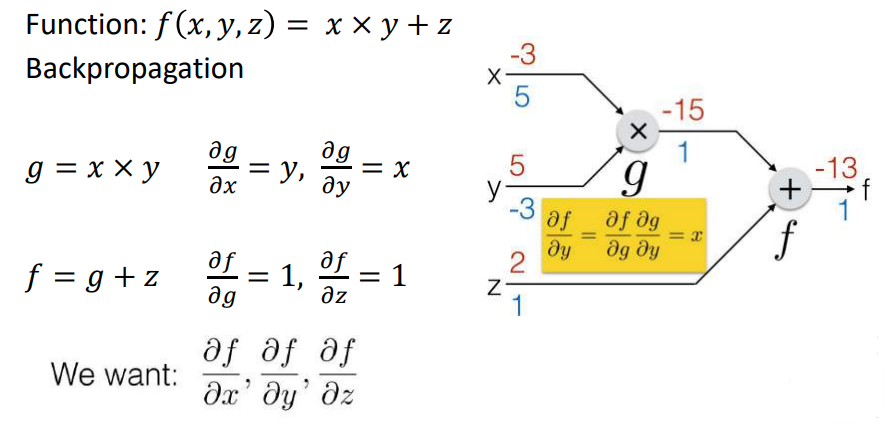

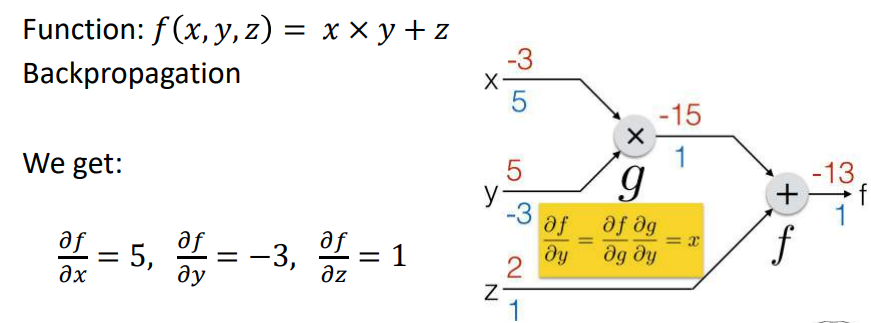

Backpropagation 역전파

나의첫 5.8.4장 p.207

밑시딥 5장 p.148~188

옵티마이저는 손실함수의 값을 최저로 하기 위해 역전파를 사용해 딥러닝 모델의 모든 매개변수를 변경함.

손실함수의 값을 최저로 한다는 뜻은 정답과 예측값의 차이를 최소화한다는 뜻이며,

쉽게 말해 모델의 에러율을 최저로 줄인다는 의미임.

Weights can be learned using backward propagation

Example..

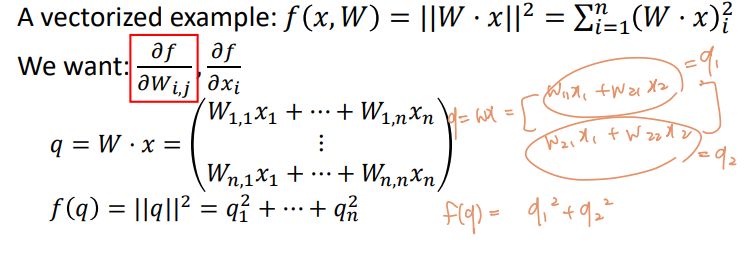

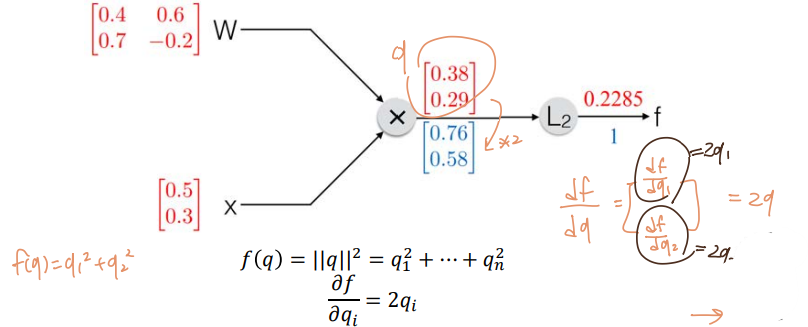

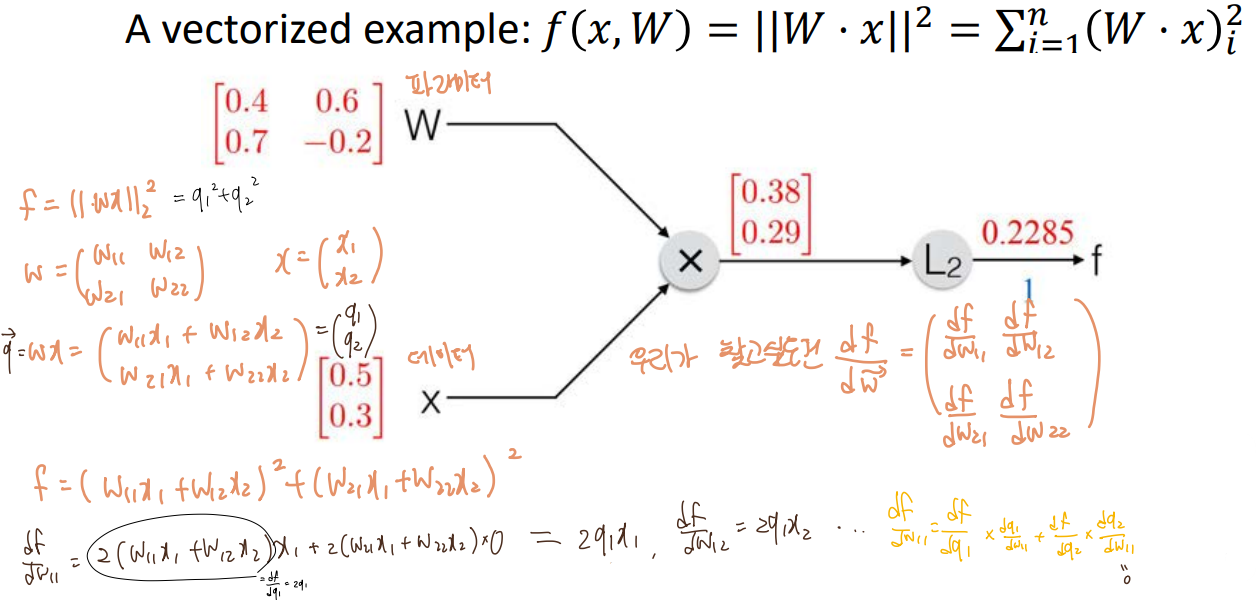

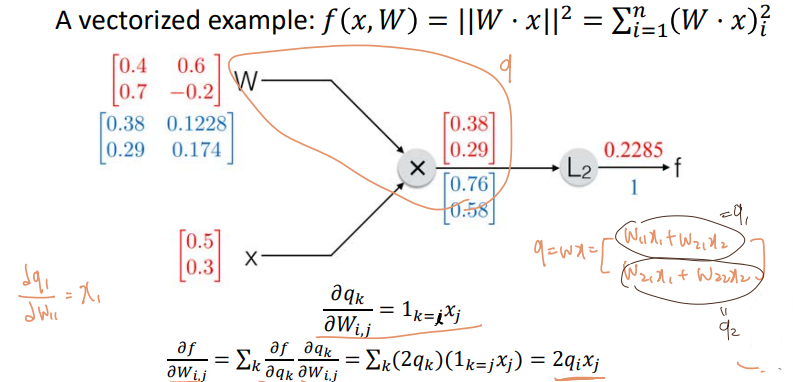

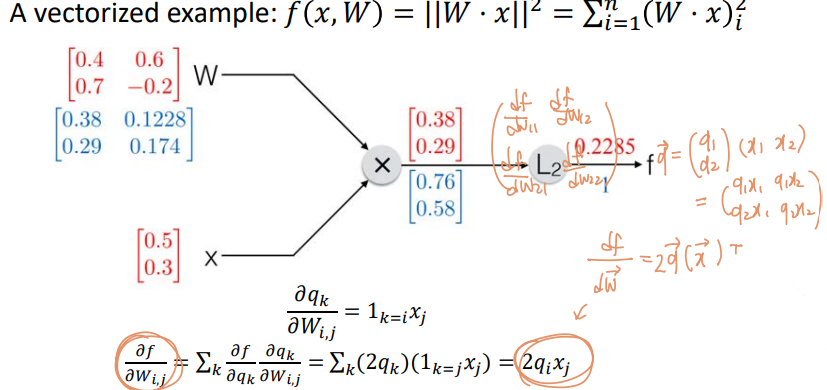

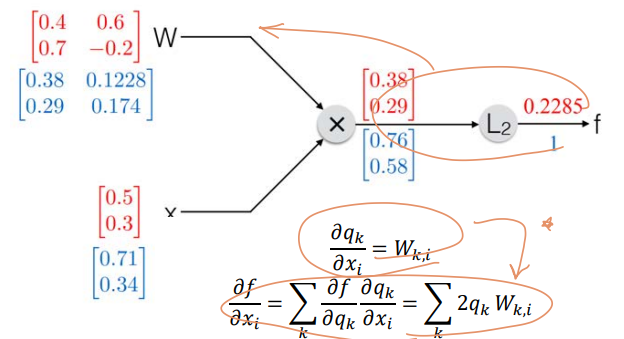

Vectorized Example..

* sigmoid (function)

: 기울어진 S 자 형태 의 곡선. sigmoid라는 말 자체가 S자 모양을 뜻함.

* ReLU 함수

: 정류 선형 유닛에 대한 함수.

ReLU는 입력값이 0보다 작으면 0으로 출력, 0보다 크면 입력값 그대로 출력하는 유닛임.

'CS > 3-2 딥러닝' 카테고리의 다른 글

| [비디오이미지프로세싱] 17. Convolutional Neural Networks (0) | 2022.10.19 |

|---|---|

| [비디오이미지프로세싱] 11~13. k-means, Principal Component Analysis (0) | 2022.10.19 |

| [비디오이미지프로세싱] 08~10. Support Vector Machine (1) | 2022.10.19 |

| [비디오이미지프로세싱] 05~07. Stochastic Gradient Descent, K-Nearest Neighbors (0) | 2022.10.19 |

| [비디오이미지프로세싱] 03~04. Linear Regression, Gradient Descent (0) | 2022.10.18 |

댓글